Neural Machine Translation – super simpel erklärt

Neural Machine Translation (NMT) birgt ein Paradox: Einerseits ist die Technologie – bekannt aus Online-Übersetzern wie Google Translate und DeepL – in unserem Alltag allgegenwärtig.

Andererseits ist ihre Funktionsweise derart komplex, dass sie nur wenige Eingeweihte nachvollziehen können.

Wir wollen ein wenig Licht in diese „Black Box“ bringen. Nachfolgend erklären wir neuronale maschinelle Übersetzung „für Dummies“ – in simpler, leicht verständlicher Sprache.

Die Architektur von Neural Machine Translation

Im Jahr 2017 veröffentlichte ein Team von Google ein wegweisendes Forschungspapier. Der Titel: Attention Is All You Need.

Was es mit diesem mysteriösen Namen auf sich hat, klären wir später noch. Fest steht in jedem Fall: Es hat die Art und Weise, wie Maschinen menschliche Sprache verstehen, für immer verändert.

Nicht zuletzt ebnete die Publikation den Weg für das heute dominante Modell für maschinelle Übersetzung: Transformer. Das steht übrigens auch hinter Large Language Models wie ChatGPT (GPT steht für Generative Pre-trained Transformer).

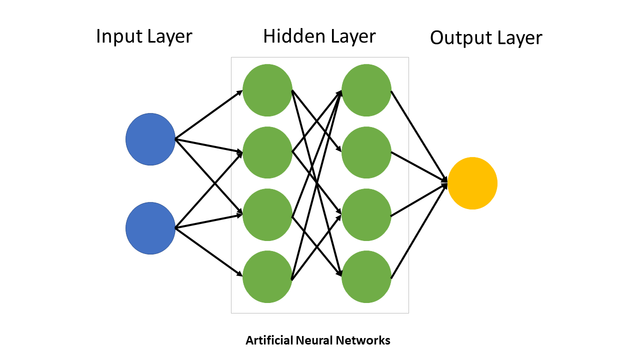

Das Transformer-Modell basiert auf einem neuronalen Netz, das aus tausenden oder Millionen künstlicher Neuronen besteht. Stark vereinfacht sieht ein solches Netzwerk folgendermaßen aus:

„Neural network explain“ von TseKiChun. Lizenziert unter CC BY 4.0

Die Neuronen im Input Layer erhalten dabei externe Stimuli – in unserem Fall wäre das der zu übersetzende Text. Weiterhin gibt es Neuronen im Output Layer, die das gewünschte Resultat der Berechnung, also hier die fertige Übersetzung, liefern.

Darüber hinaus gibt es Neuronen in den inneren Schichten, die nur Signale von anderen Neuronen empfangen. Die Art ihrer Interaktion bemisst sich aus der Stärke ihrer Verbindungen untereinander (sogenannte Weights).

Hat ein neuronales Netz eine Vielzahl solcher Schichten, nennt man es Deep Neural Network. Es ist dann für Deep Learning ausgelegt und kann besonders komplexe Aufgabenstellungen bewältigen.

Übrigens: Googles NMT-Architektur hat 8 Schichten, während GPT-4, auf dem die aktuelle Version von ChatGPT basiert, 120 solcher Schichten besitzt.

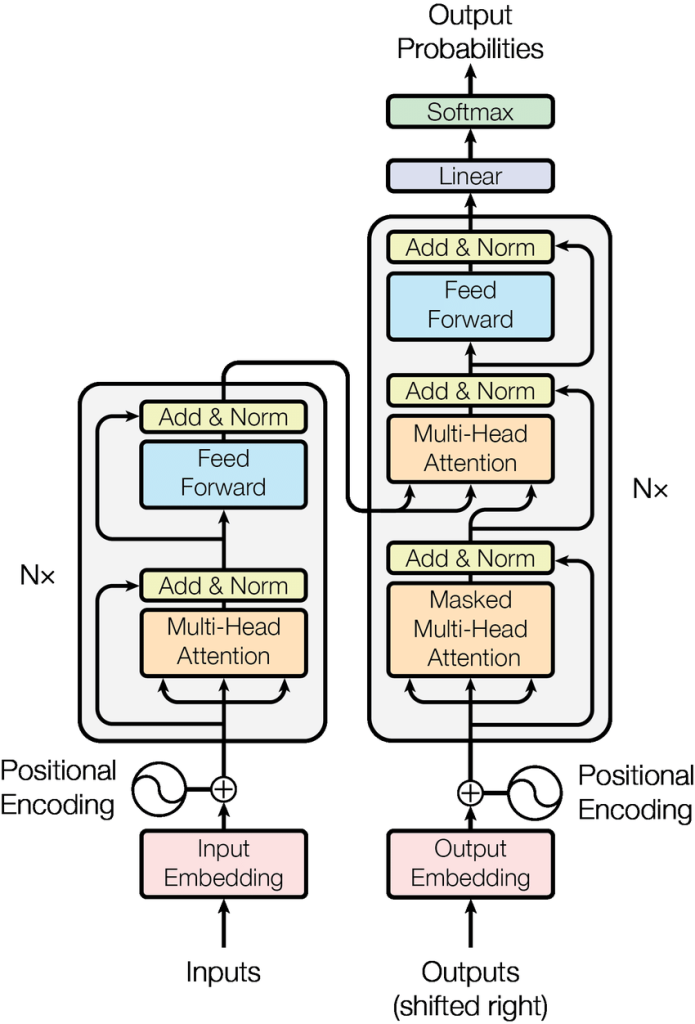

Doch kehren wir zurück zum Transformer-Modell. Im Detail stellt sich eine solche Architektur wie folgt dar:

Architektur des Transformer-Modells (Quelle: Vaswani et al.: Attention Is All You Need)

Keine Panik – ein Detailverständnis dieses Schemas ist nicht nötig! Ganz grob soll aber gesagt sein, dass es sich dabei um eine Encoder-Decoder-Architektur handelt, die durch einen sogenannten Attention-Mechanismus verbunden ist.

Was bedeutet all das? Und wie entsteht in diesem System eine Übersetzung? Das schauen wir uns im Folgenden an.

Wie funktioniert Neural Machine Translation denn nun genau?

Unser Startpunkt ist der Input Layer, der mit dem Encoder verbunden ist.

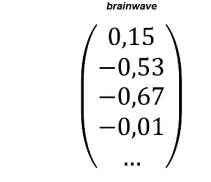

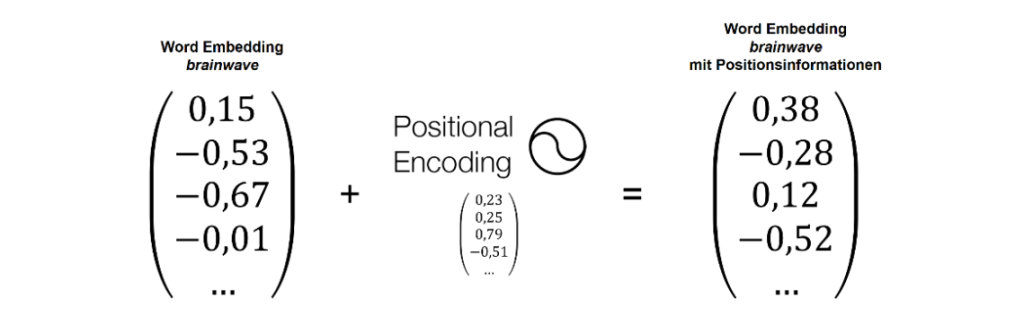

Dort wird im ersten Schritt der Text, den wir übersetzen möchten, für die Maschine lesbar gemacht. Denn die versteht keine menschliche Sprache, sondern nur Zahlen. Konkret handelt es sich in unserem Fall dabei um Vektoren. Nachfolgend wird das Wort „brainwave“ durch einen Vektor dargestellt:

Quelle: Krüger: Transformer-Architektur

Wie man sieht, ist ein Vektor eine spaltenweise angeordnete Reihe von Zahlen. Jede Zahl innerhalb der Klammer steht für eine Vektordimension.

Ein derartiger Vektor wird auch Word Embedding genannt. Er ähnelt der Bedeutung eines Wortes, wie man sie in einem Wörterbuch findet.

Je mehr Dimensionen ein Vektor aufweist, desto mehr Bedeutungsnuancen können für ein Wort erfasst werden. Große neuronale Netze können pro Wort hunderte oder gar tausende solcher Dimensionen enthalten.

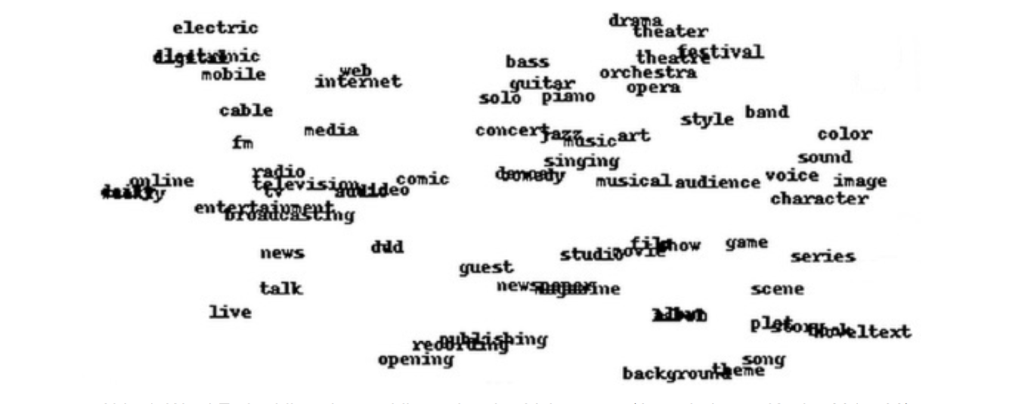

Wörter, die eine ähnliche Bedeutung aufweisen oder im selben Kontext auftreten, sind in diesem Vektorraum in räumlicher Nähe zueinander angeordnet und bilden Cluster:

Quelle: Koehn: Neural Machine Translation

Dieses semantische „Know-how“ von Transformern ist an und für sich schon beeindruckend.

Allerdings reicht das noch lange nicht für eine gute Übersetzung aus. Denn Informationen zum Kontext der Übersetzung fehlen Transformern zu diesem Zeitpunkt noch völlig.

Nehmen wir den folgenden Satz:

Gestern abend habe ich mir zuhause eine Platte von den Beatles angehört.

Menschen wissen intuitiv, dass es sich bei „Platte“ um eine Schallplatte und nicht etwa um eine Steinplatte handelt. Darauf lassen kontextverwandte Wörter wie „anhören“ oder „Beatles“ schließen.

Genau diesen Kontext benötigt auch Neural Machine Translation. Dafür werden unsere Word Embeddings nun durch sogenannte Positional-Encoding-Vektoren angereichert. Die enthalten Informationen zur Wortreihenfolge und zur Position der einzelnen Wörter im zu übersetzenden Satz.

Berechnung eines Word Embeddings mit Positionsinformationen (Quelle: Krüger: Transformer-Architektur)

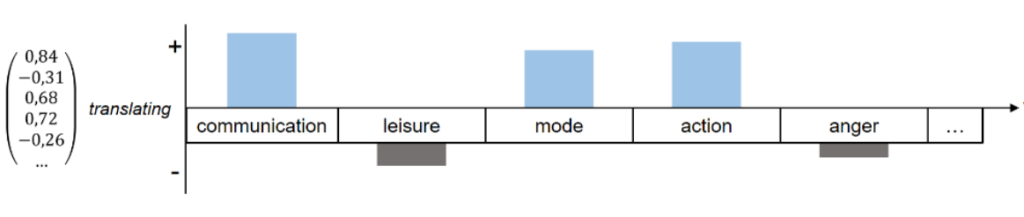

Übrigens: Jede Vektordimension weist eine Zahl zwischen -1 und 1 auf. Je höher der Zahlenwert, desto ähnlicher sind sich zwei Wortvektoren oder Wörter. Je niedriger dieser Wert, desto weniger ähneln sich die beiden Vektoren. Wie das funktioniert, lässt sich am besten an einem Beispiel verdeutlichen:

Quelle: Krüger: Transformer-Architektur

In der obigen Abbildung hat das Wort „translating“ (links) eine inhaltliche Nähe zu Wörtern wie „communication“ und „action“. Diese Nähe ist auch in den positiven Vektordimensionen für „communication“ (0,84) und „action“ (0,72) reflektiert, die beide auf eine semantische Übereinstimmung hindeuten.

Wörter wie „anger“ (-0,26) oder „leisure“ (-0,31) haben hingegen einen geringen Verwandtschaftsgrad zum Themenkomplex Übersetzung, was sich in einem negativen Zahlenwert äußert.

Wir haben also gelernt, dass Transformer unzählige Daten zur semantischen Bedeutung und dem Kontext von Texten speichern.

Wie aber wird nun aus diesem Zahlenchaos eine brauchbare Übersetzung?

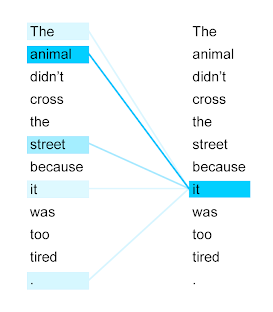

Das Zauberwort lautet Attention. Dieser Mechanismus entscheidet darüber, wohin die Maschine bei der Übersetzung ihre Aufmerksamkeit richtet. Genauer gesagt wird ein Blick auf sämtliche Wörter der Input-Sequenz geworfen und analysiert, wie relevant diese Wörter für die Verarbeitung des aktuellen Worts sind.

Self-Attention erkennt, dass sich „it“ auf „animal“ statt auf „street“ bezieht. (Quelle: Google Research Blog)

Der Attention-Mechanismus wird insgesamt achtmal parallel durchgeführt. Durch die Kombination unterschiedlicher Aufmerksamkeitsverteilungen wird eine präzisere kontextualisierte Repräsentation der Input-Sequenz erzeugt, als dies durch eine einzelne Aufmerksamkeitsverteilung möglich wäre.

Nun kommt der letzte Schritt: Der Generierung des Zieltextes. Dieser Prozess erfolgt Wort für Wort, also sequenziell.

Dabei wird anhand der Vektorrepräsentation des Ausgangstextes eine Art „Wahrscheinlichkeits-Score“ für jedes mögliche Zielwort in der Übersetzung generiert. Wichtig für akkurate Übersetzungen: Bei der Textgenerierung werden gleichzeitig auch die bisher schon übersetzten Wörter berücksichtigt. Ein solches Vorgehen nennt man auto-regressiv.

Und schwupps – einen Sekundenbruchteil und mehrere Millionen Rechenoperationen später haben wir eine fertige Übersetzung!

Was ist an Neural Machine Translation so revolutionär?

Die Transformer-Architektur ist der unangefochtene Benchmark für maschinelle Übersetzung. Dafür gibt es mehrere Gründe:

- Zum einen werden Bedeutungsnuancen im Ausgangstext dank dem Attention-Mechanismus stärker reflektiert. Auch das „Verständnis“ syntaktischer Strukturen und allgemeiner Sprachregeln ist beachtlich: Übersetzte Texte lesen sich in der Regel flüssig, Rechtschreib- und Grammatikfehler kommen kaum noch vor.

- Darüber hinaus hat sich das „Gedächtnis“ der Maschine verbessert. Vorgängertechnologien wie Recurrent Neural Networks hatten oft Probleme mit längeren Sätzen: Mit fortschreitender Textgenerierung vergaß die Maschine schlicht, was am Anfang eines Satzes stand, was eklatante Übersetzungsfehler zur Folge hatte. Bei moderner Neural Machine Translation werden längere Inputsequenzen zuverlässiger und stimmiger übersetzt.

- Ebenso beeindruckend ist die Fähigkeit zur Generalisierung. Neuronale maschinelle Übersetzung kann auch hervorragend Sätze übersetzen, die nicht bereits eins zu eins in ihrem Trainingskorpus enthalten sind. Diese Transferleistung kann mit Kindern verglichen werden, die beim Spracherwerb zunächst nur das Gehörte „nachplappern“ und schließlich irgendwann dazu übergehen, eigenständig neue Sätze zu bilden.

- Auch aus technischer Sicht vollziehen Transformer-Modelle einen Quantensprung, da Daten nicht länger sequenziell, sondern parallel verarbeitet werden. Bei früheren Modellen wurde jedes Wort bei der Übersetzung einzeln verarbeitet – ein langsamer und ineffizienter Prozess. In Transformern werden hingegen sämtliche Wörter einer Input-Sequenz in einem Schritt direkt aufeinander bezogen. Dadurch können Hardwarekomponenten wie Graphical Processing Units (GPUs) oder Tensor Processing Units (TPUs), die für die parallele Verarbeitung großer Datenmengen ausgelegt sind, optimal genutzt werden.

Wo liegen die Grenzen von Neural Machine Translation?

Was ein Transformer sprachlich produziert, ist erstaunlich. Dennoch handelt es sich im Grunde „nur“ um einen talentierten Illusionskünstler.

Denn Textverständnis im menschlichen Sinne besitzt die Maschine nicht. Im Kern berechnet ein Transformer die statistische Wahrscheinlichkeit einer bestimmten Abfolge an Wörtern. Wort für Wort, ohne Gespür für Bedeutung nach menschlichem Maßstab. Keine Magie also, sondern schnöde Mathematik.

Auch die sprachliche Qualität ist bei genauerem Hinsehen oft ernüchternd. Nicht selten entsteht ein textlicher „Einheitsbrei“, zusammengerührt aus einem riesigen Textkorpus. Einzigartige Texte mit Persönlichkeit? Fehlanzeige. Noch akuter ist dieses Phänomen bei weniger verbreiteten Sprachen oder Sprachen mit stark abweichenden grammatikalischen Strukturen.

Ebenso limitiert ist das Kontextwissen – das endet für neuronale maschinelle Übersetzung nämlich an der Textgrenze. Ist das englische Wort „menu“ nun eine Speisekarte oder das Textmenü einer Software? Liefert der Text selbst keine Antwort auf diese Frage, ist die Maschine machtlos. Erschwert wird dieses Problem noch in Übersetzungssoftware, wo aufgrund von Segmentierung jedes Segment isoliert übersetzt wird.

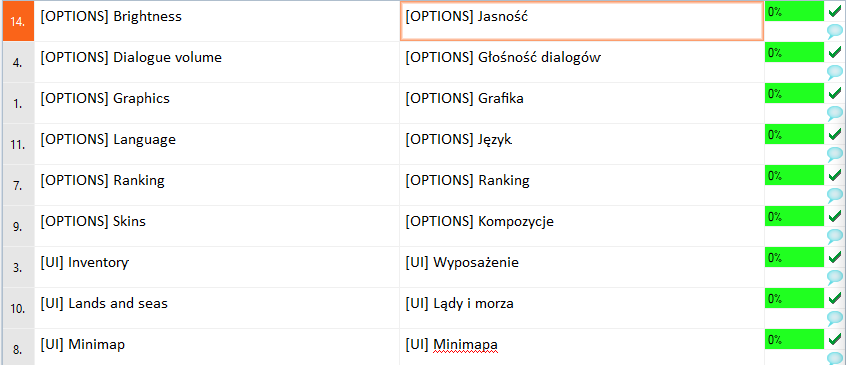

CAT-Tools unterteilen Text in Segmente, was den verfügbaren Kontext für neuronale maschinelle Übersetzung limitiert (Quelle: memoQ.com)

Ein menschlicher Übersetzer zieht in solchen Zweifelsfällen externes Referenzmaterial heran oder hält Rücksprache mit dem Autor des Textes. Daneben können Menschen natürlich auch auf ein viel breiteres Weltwissen zurückgreifen und sich auf ihr kulturelles Gespür verlassen – ganz zu schweigen von ihrer Vertrautheit mit aktuellen gesellschaftlichen Diskursen und Entwicklungen, die oft indirekt in Übersetzungen einfließen.

Ein weiteres bekanntes Problem bei Neural Machine Translation ist mangelnde Vorhersagbarkeit und Transparenz. Denn wie genau die KI zu einem Übersetzungsvorschlag gelangt, ist nicht endgültig nachvollziehbar oder gar direkt steuerbar. Gerade beim Thema Terminologie übersetzen die Systeme stark inkonsistent, was in regulierten Branchen oder bei strengen Qualitätsanforderungen problematisch ist. Hier kann ein standardisierter Post-Editing-Prozess Abhilfe schaffen.

Was sind die besten Systeme für Neural Machine Translation?

Der Pionier, der Neural Machine Translation salonfähig gemacht hat, ist Google Translate. Weitere populäre Alternativen, die Google qualitativ kaum nachstehen, sind DeepL, Microsoft Translator und Amazon Translate. Sind Sie auf der Suche nach dem richtigen neuronalen Übersetzungssystem für Ihr Unternehmen? Ein ausführliches Ranking der besten KI-Übersetzer finden Sie in unserem Blog.

Ausblick

Neural Machine Translation ist ein Meilenstein im Bereich Natural Language Processing. Allerdings stagniert die Technologie seit 2017 auf hohem Niveau. Hat NMT seinen Zenit deshalb bereits überschritten? Wohl kaum! Der nächste Schritt besteht darin, neuronale maschinelle Übersetzung mit anderen KI-Technologien wie Large Language Models zu verschmelzen. So nutzt Google Translate bereits die hauseigene generative KI Google Gemini, um die Korrektheit und Flüssigkeit seiner Übersetzungen zu verbessern. Für Unternehmen eröffnet das faszinierende Perspektiven, wie sich Inhalte in Zukunft übersetzen lassen.